Selon Forester, les dépenses en logiciels d’IA devraient presque doubler, passant de 33 milliards de dollars (31 milliards d’euros) en 2021 à 64 milliards de dollars (60 milliards d’euros) en 2025, une accélération bien plus rapide que celle du marché global des logiciels.

Avec le lancement en 2024 de GPT-4o ou de Deep Research en février 2025, Chat GPT continue sa fulgurante ascension et son usage tend à devenir chaque jour une norme quotidienne au sein des entreprises.

Face à cet avènement des modèles de traitement de langage naturel tels que Chat GPT, ou encore DALL-E, autre branche d’OpenAI pour la génération d’image, les entreprises sont confrontées à de nouveaux risques en matière de sécurité des données sensibles.

Découvrez dans cet article les risques d’utilisation de Chat GPT en entreprise en ce qui concerne les données sensibles et comment les entreprises peuvent atténuer ces risques.

Risque de diffusion des données sensibles sur Chat GPT

Chat GPT utilise l’apprentissage automatique pour générer des réponses aux questions posées par les utilisateurs. Cela signifie que les réponses générées sont basées sur les données qui ont été utilisées pour alimenter/entraîner l’algorithme.

Si ces données incluent des informations sensibles telles que des informations de carte de crédit ou des données médicales, l’utilisation de Chat GPT peut potentiellement exposer ces informations sensibles à des tiers non autorisés.

De plus, comme Chat GPT peut apprendre et s’adapter en temps réel, il existe un risque que les réponses générées par l’algorithme deviennent de plus en plus imprévisibles et incohérentes avec le temps. La donnée peut ainsi être diffusée puis adaptée et donc modifiée.

Partagez et collaborez en sécurité

Collaborez en toute confiance sur vos fichiers sensibles dans un environnement sécurisé et souverain grâce à Oodrive Work

Conséquences de l’exposition des données sensibles

L’exposition des données sensibles peut avoir des conséquences graves pour les entreprises, notamment en termes de responsabilité juridique, de réputation de marque et de perte de confiance des clients.

Si les données des clients sont exposées, les entreprises peuvent être tenues responsables de toute utilisation abusive ou frauduleuse de ces données. De plus, les entreprises qui ne protègent pas les données de leurs clients peuvent perdre la confiance des clients et leur réputation peut être gravement ternie.

Plus de confidentialité en 2025 sur Chat GPT ?

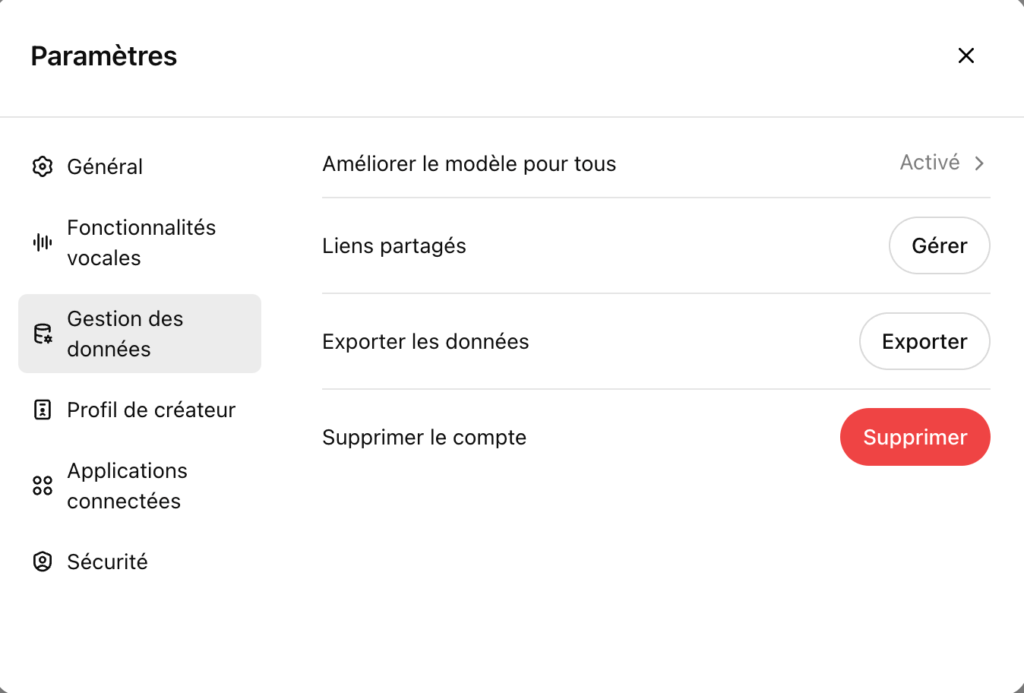

En 2025, OpenAI tend vers une confidentialité accrue en rendant Chat GPT accessible sans créer de compte. Cette fonctionnalité s’accompagne d’une plus grande maîtrise des données par les utilisateurs.

En respectant quelques étapes dans les réglages, les utilisateurs ont la possibilité de refuser de partager leurs données à destination des contributions des utilisateurs de Chat GPT. Pour désactiver l’utilisation de ses données par Chat GPT, cliquez sur l’icône Profil en haut à droite, puis « Paramètres » et « Gestion des données » et « Améliorer le modèle pour tous : Désactivé « . Cela empêchera d’envoyer vos informations en tant que contribution pour améliorer cette IA.

Comment atténuer les risques liés à l’utilisation de Chat GPT

Les entreprises peuvent prendre plusieurs mesures. Elles doivent s’assurer que les données sensibles ne sont pas utilisées pour entraîner l’algorithme de Chat GPT. En faisant de la pédagogie notamment.

Ensuite, les entreprises peuvent limiter les types de données que Chat GPT est autorisé à traiter et à stocker. Elles peuvent mettre en place des contrôles d’accès et des politiques de sécurité pour s’assurer que seules les personnes autorisées ont accès aux données sensibles.

Enfin, elles peuvent mettre en place des processus de surveillance et de gestion des risques pour s’assurer que tout incident de sécurité est identifié et traité rapidement.

Classification et protection des données sensibles

Protégez et sécurisez vos données sensibles grâce au SecNumCloud

De la même manière que pour tout autre menace, pour se protéger, les entreprises doivent faire un audit pour connaitre leur taux de vulnérabilité.

Les tests de pénétration (ou « pen testing ») sont un moyen efficace de simuler une attaque sur leurs systèmes ou applications, afin d’identifier les failles de sécurité qui pourraient être exploitées par des acteurs malveillants.

Dans le contexte de l’essor de ChatGPT, ces tests sont d’autant plus importants pour garantir la confidentialité, l’intégrité et la disponibilité des systèmes.

Sans aller jusqu’à l’interdiction pure et simple d’utiliser Chat GPT, cela revenant en 2025 à interdire d’utiliser Google, les entreprises ont aujourd’hui plutôt un intérêt d’encadrer l’utilisation et former leurs collaborateurs aux bonnes pratiques.

L’une des pistes la plus en vogue au sein des entreprises les plus soucieuses de la sécurité de leurs données est aussi la création de son « propre Chat GPT ». Lancée en 2020 avec de nombreuses évolutions jusqu’en 2025, il est en effet possible d’utiliser l’API d’OpenAI pour créer un modèle personnalisé. Il sera ainsi possible d’héberger la solution en interne, pour encore plus de contrôle et de sécurité.

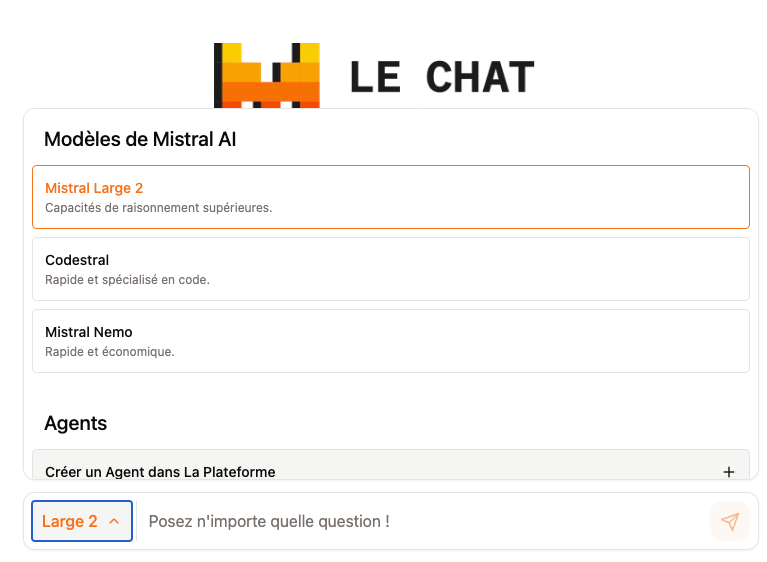

Mistral, la solution souveraine à Chat GPT ?

Cela amène aussi à la question des alternatives européennes possibles à Chat GPT, avec par exemple le lancement en 2024 de Mistral Chat, IA générative française et similaire à Chat GPT.

Mistral ambitionne de devenir un acteur clé de l’intelligence artificielle en Europe, en mettant notamment en avant un modèle open-source et souverain. Avec une levée de fonds de 400 millions d’euros en 2024 et le soutien de nombreux investisseurs, l’entreprise a dévoilé Mixtral, un modèle conçu pour offrir un équilibre entre performance et efficacité énergétique.

Si Mistral affiche de grandes ambitions, elle doit encore faire ses preuves face aux géants américains et chinois du secteur, avec notamment la sortie récente de DeepSeek. L’un de ses principaux atouts repose sur sa capacité à proposer des modèles plus transparents et hébergeables sur des infrastructures privées, permettant ainsi aux entreprises de garder le contrôle total sur leurs données sensibles.

En se positionnant comme une alternative européenne conforme aux exigences du RGPD, Mistral cherche à répondre aux préoccupations des entreprises en matière de souveraineté numérique et de sécurité des données. Toutefois, son adoption à grande échelle reste un défi, et il lui faudra convaincre par la qualité de ses modèles et la robustesse de son infrastructure pour espérer rivaliser avec les solutions d’OpenAI ou de Google.

En suivant des mesures de sécurité appropriées, les entreprises pourraient pourtant tirer parti de Chat GPT pour améliorer leur efficacité opérationnelle tout en protégeant les données sensibles de leurs clients.

Comme il y a quelques années, les réseaux sociaux étaient interdits dans certaines entreprises, parce qu’il s’agissait encore d’un monde inconnu, les entreprises ont aujourd’hui réussi à dompter et utiliser ces plateformes pour leur image, notoriété et business.

Nous pouvons donc penser que, passée la phase de découverte, les entreprises sauront tirer profit de cet outil. Encore faut-il sécuriser ses données et faire de l’éducation auprès de ses collaborateurs !

Open AI, reste une entreprise comme une autre, qui elle aussi peut subir des attaques, comme Facebook, Google etc. Preuve en est, en mars dernier. L’AI n’exempte pas (encore) des attaques !