L’IA connaît depuis plusieurs années un essor fulgurant, avec des impacts importants sur l’économie et la société. Alors qu’elle permet de gagner en productivité, en automatisant un certain nombre de tâches et en analysant de grandes quantités de données, l’utilisation de systèmes d’IA est également source de risques. L’IA est en effet susceptible de porter atteinte aux droits fondamentaux des personnes (discrimination, manquements en matière de protection des données, etc.).

Afin de répondre aux défis posés par l’IA, tout en bénéficiant des opportunités offertes par cette technologie, l’Union européenne a souhaité se doter d’une législation sur le sujet : l’IA Act. Avec ce règlement, l’UE souhaite promouvoir une IA éthique et de confiance, en encadrant son utilisation, tout en préservant l’innovation et la compétitivité européenne dans cette course technologique. Il s’agit du premier cadre réglementaire au monde portant sur l’IA.

Quel est le contenu de l’IA Act ? Quels sont ses objectifs, les acteurs concernés et leurs obligations de mise en conformité ? Cet article compile les différents éléments essentiels à connaître sur l’IA Act.

Qu’est-ce que l’IA Act ?

L’IA Act est le premier cadre réglementaire au monde portant sur l’intelligence artificielle, adopté par le Parlement européen en mars 2024. La vocation de ce texte est d’encadrer les usages de l’IA en parvenant à un équilibre entre protection des droits fondamentaux, sécurité des citoyens, développement d’une IA responsable et soutien à l’innovation.

La mise en œuvre de l’IA Act s’effectuera de manière échelonnée. Les entreprises concernées auront ainsi le temps de se conformer progressivement aux exigences posées par ce texte. Le Bureau européen de l’IA est chargé de la mise en œuvre et de l’application de ce règlement.

Quels sont les objectifs de l’IA Act ?

L’IA Act poursuit plusieurs grands objectifs :

- Garantir que les systèmes et modèles d’IA commercialisés au sein de l’UE soient sécurisés, utilisés de manière éthique et respectent les droits fondamentaux de l’UE.

- Stimuler la compétitivité, les investissements et l’innovation des entreprises en matière d’IA, notamment grâce à un cadre juridique uniforme.

- Renforcer la confiance des citoyens dans l’utilisation et l’adoption de cette technologie en promouvant une IA de confiance.

Quels sont les acteurs concernés ?

L’IA Act s’impose aux différents acteurs impliqués dans le développement, le déploiement et la gestion des systèmes d’IA, notamment : les fournisseurs, distributeurs, développeurs et déployeurs de systèmes et de modèles d’IA, personnes morales dont le siège social est situé au sein de l’UE.

Les personnes morales dont le siège est situé en dehors de l’UE sont également concernées si elles commercialisent leur système ou modèle d’IA dans l’Union européenne.

Le texte prévoit des sanctions en cas de non-respect. Ces sanctions vont de 7,5 à 35 millions d’euros ou de 1 à 7 % du chiffre d’affaires annuel global de l’entreprise.

Quel est le contenu de la réglementation sur l’IA en Europe ?

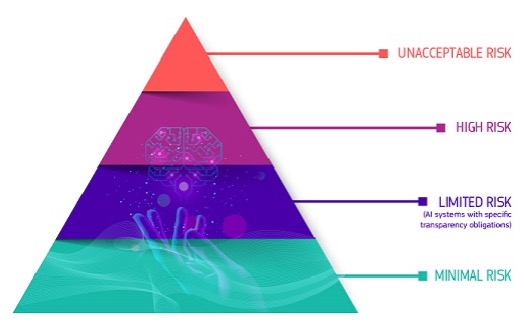

L’IA Act adopte une approche pragmatique fondée sur les risques. Le texte classe les systèmes d’IA selon leur usage et non leur technologie. Les obligations sont adaptées au niveau de risques.

4 niveaux de risques et d’obligations

L’IA à risque inacceptable : les systèmes et modèles d’IA contraires aux valeurs de l’Union européenne et aux droits fondamentaux sont interdits (pas de commercialisation au sein de l’UE, pas d’export).

Exemples : notation sociale, recours à des techniques subliminales, police prédictive, reconnaissance des émotions sur le lieu de travail et dans les établissements d’enseignement, etc.

L’IA à haut risque : le développement de systèmes et de modèles d’IA susceptibles de porter atteinte à la sécurité des personnes ou à leurs droits fondamentaux est soumis à des exigences renforcées. Ces systèmes et modèles doivent faire l’objet d’un marquage « CE » afin de pouvoir être commercialisés.

L’IA à risque faible ou présentant des risques en matière de transparence : ces systèmes et modèles sont soumis à des obligations d’information et de transparence vis-à-vis des utilisateurs.

L’IA à risque minime : pas d’obligation spécifique, application volontaire de pratiques de bonne conduite.

Source : https://digital-strategy.ec.europa.eu/fr/policies/regulatory-framework-ai

Le cas des modèles d’IA à usage général

Le texte impose également des obligations particulières à la catégorie des modèles d’IA à usage général (notamment dans le domaine de l’IA générative). L’IA Act prévoit pour ces textes différents niveaux d’obligations : mesures de transparence et de documentation minimales, évaluation approfondie et mise en place de mesures d’atténuation des risques systémiques que certains modèles d’IA sont susceptibles de comporter.

Quel est le calendrier de l’IA Act ?

Le règlement européen sur l’IA est paru au Journal officiel de l’Union européenne (JOUE) le 12 juillet 2024. Il est entré en vigueur 20 jours après sa parution au JOUE, soit le 1er août 2024.

L’IA Act fera ensuite l’objet d’une mise en application échelonnée de 6, 12, 24 et 36 mois après son entrée en vigueur, en fonction du niveau de risques des systèmes et modèles d’IA.

| 2 février 2025 | 6 mois après l’entrée en vigueur | Interdiction des systèmes d’IA présentant un risque inacceptable. |

| 2 août 2025 | 12 mois après l’entrée en vigueur | Application des exigences pour les modèles d’IA à usage général. |

| 2 août 2026 | 24 mois après l’entrée en vigueur | Début de l’application générale du texte : application des exigences pour les systèmes d’IA à haut risque de l’annexe III, à risque faible et minime. |

| 2 août 2027 | 36 mois après l’entrée en vigueur | Application des règles relatives aux systèmes d’IA à haut risque de l’annexe I. |

Comment se préparer à l’IA Act ? Les grandes étapes

La mise en conformité à l’IA Act est une démarche exigeante, structurée en plusieurs étapes clés.

- Désigner un pilote et mettre en place une gouvernance.

- Sensibiliser l’ensemble des parties prenantes au sein de l’organisation aux implications de l’IA Act.

- Cartographier les systèmes d’IA déjà utilisés et qualifier le niveau de risques associés.

- Établir des process de mise en conformité :

- Conduire une analyse des risques associés aux systèmes d’IA.

- Établir une documentation technique relative aux processus et aspects techniques des systèmes d’IA.

- Mettre en œuvre un ensemble de mesures portant sur la gouvernance des données, la transparence, le contrôle humain, la sécurité, la journalisation ou encore le marque CE et l’enregistrement de conformité auprès de l’UE.

Le texte impose également de déployer et de mettre en œuvre un système de gestion de la qualité.

- Garder toujours en tête les valeurs fondamentales nécessaires à la mise en œuvre d’une IA « responsable ».

Les grands points à retenir sur l’IA Act, la loi européenne sur l’IA

- L’IA Act est le premier cadre réglementaire au monde sur l’intelligence artificielle, adopté par l’Union européenne en mars 2024. Ce texte ambitieux vise à encadrer l’IA et à encourager son utilisation de manière éthique, tout en soutenant l’innovation.

- Ce texte adopte une approche par les risques en distinguant 4 niveaux différents. Les obligations qui s’imposent aux acteurs concernés ne sont pas les mêmes en fonction du niveau de risques présenté par les modèles et systèmes d’IA en question. Les modèles et systèmes présentant des risques considérés comme « inacceptables » sont d’ores et déjà interdits.

- L’IA Act fera l’objet d’une application progressive et prévoit des sanctions en cas de non-respect.

- La démarche de mise en conformité à la réglementation sur l’IA en Europe nécessite une démarche structurée et exigeante. Il s’agit d’une démarche essentielle pour garantir une utilisation responsable des technologies d’IA et renforcer la confiance des citoyens dans ces dispositifs.